近期,我中心一篇关于卷积神经网络(CNN)可视化的论文“TSGB: Target-Selective Gradient Backprop for Probing CNN Visual Saliency”被CCF A类期刊《IEEE Transactions on Image Processing》接收。TIP是计算机视觉领域的国际顶级期刊,其影响因子为10.856。

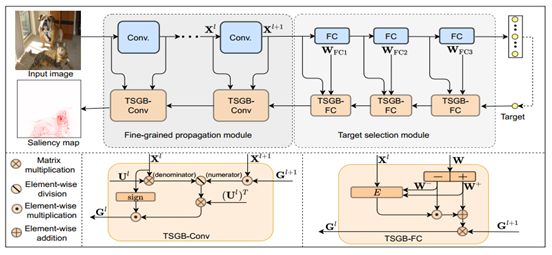

最近几年随着深度学习的火热发展,对神经网络的设计和应用得到了广泛的研究,但是对神经网络的理解长期被当做黑盒子问题。该论文利用视觉显著性,尝试从视觉层面对卷积神经网络进行解释,或者说对CNN进行可视化。在现有的可视化技术中,大多数方法要么难以产生精细的显著性图(如CAM),要么产生的细粒度的显著性图不具有目标选择性(如GradBP)。也就是说,使用一次梯度反向传播,生成同时满足目标选择性、细粒度的、且可靠的显著性图,在该领域是一个具有挑战性的问题。为了缓解这个问题,该论文重新研究了网络内部的梯度流,发现纠缠的语义和原始权重可能会干扰与目标相关的梯度的传播。受这些观察结果的启发,该论文提出了一种新颖的视觉显著性方法,称为目标选择梯度反向传播(TSGB),它利用校正操作,有效地强调目标类,并进一步有效地将显著性传播到输入空间,从而生成具有目标选择性和细粒度的显著性图。在ImageNet和Pascal VOC上进行了大量的定性和定量实验,结果表明,该方法比其他竞争性方法获得了更准确、更可靠的结果。代码已开源并将进一步完善https://github.com/123fxdx/CNNvisualizationTSGB。

该论文由我中心博士生程林等完成,由厦门大学王菡子教授和浙江大学沈春华教授联合指导。该研究工作得到了国家自然科学基金项目的支持。